缘起

本来想用DeepSeek来干点活,但涉及数据安全,公网的API是指望不上了,不敢用,也不允许用。考虑本地部署,但就单位给的那点工资,别说啥4090了,就是Tesla P4也买不起了话说。

上周某个同事在单位给的那个几百年前买的联想笔记本显卡上跑了1.5b,那第一反应是那破烂玩意儿就一个集成显卡,那我dell r720服务器双核40线程不比他的笔记本强大多了。

硬件

戴尔服务器PowerEdge R720

CPU:20 CPUs x Intel(R) Xeon(R) CPU E5-2660 v2 @ 2.20GHz

内存:64G

系统:ubuntu 22.04 server

安装ollama

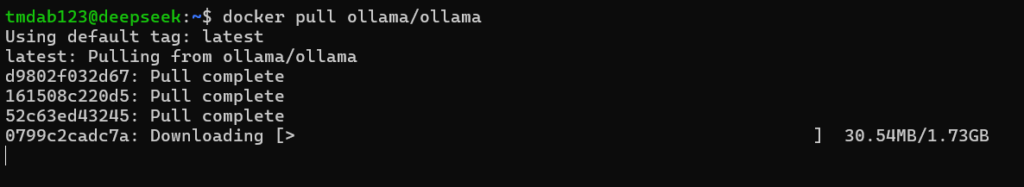

拉取ollama镜像

docker pull ollama/ollama

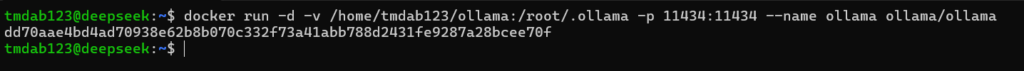

运行ollama

mkdir -p ollamadocker run -d -v /home/tmdab123/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

ollama已运行

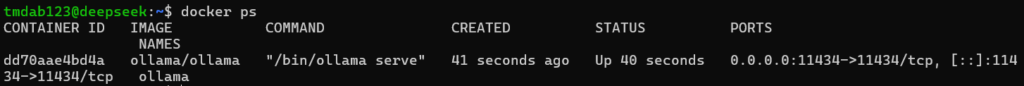

下载deepseek的模型

很显然,就这硬件性能,7B以上的模型你想都别想,先搞个1.5B的测试看看

docker exec -it dd70aae4bd4a bash拉取模型

具体的拉取模型参考从这个URL地址获取

https://ollama.com/library/deepseek-r1:1.5b

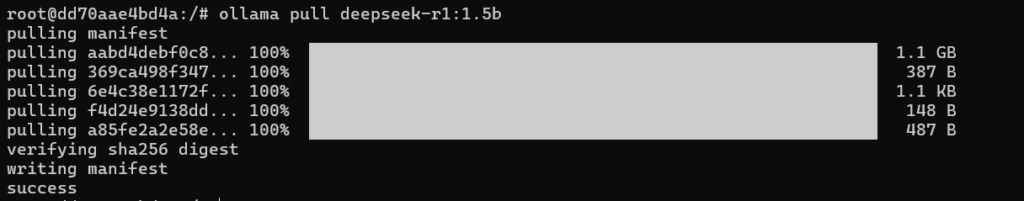

拉取1.5B,大小大概1.5G左右

下载完成后,我们跑起来看看

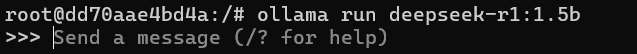

ollama run deepseek-r1:1.5b

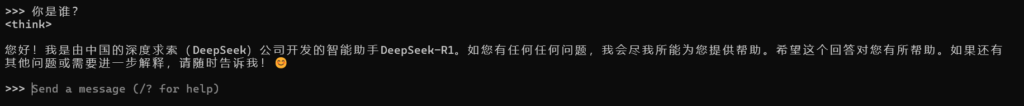

问个问题看看

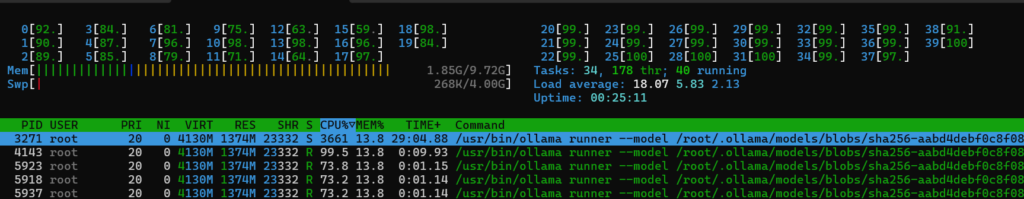

基本上2S/token,这速度也没谁了,40线程的CPU基本全部跑满,我特么……

为啥至强的E5这么弱的吗????????

缘灭

事实证明,在没有GPU的加持下,本地部署基本不可用,除了用来熟悉本地部署外,其他没啥意义。